Rendimiento de un agente de IA 📊

Rendimiento de un agente de IA 📊

Caso práctico: Chatbot de IA para la educación sobre el cannabis medicinal

Descripción general del proyecto

Se implementó un chatbot de inteligencia artificial, «PEP», para ayudar a los pacientes y consumidores de atención médica respondiendo a las preguntas más comunes sobre el cannabis medicinal. El objetivo era ayudar a los usuarios a obtener información sobre las dosis, los posibles beneficios y riesgos del cannabis y, en última instancia, permitirles tomar decisiones informadas. Para evaluar el rendimiento del chatbot, se rastrearon cuatro métricas clave: Consultas incorrectas/no respondidas, Entrega, Alucinaciones, y Consiga convertirse en un ser humano (médico). Estos son los detalles del proyecto.

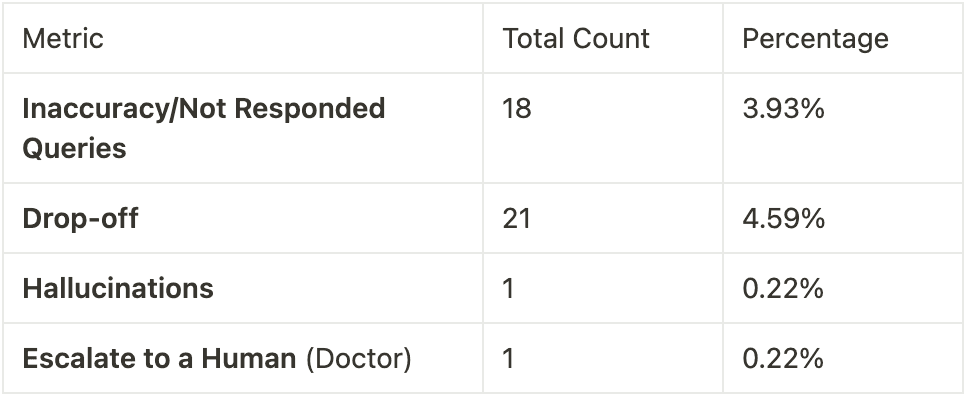

Métricas de rendimiento

Definiciones

- Consultas inexactas o no respondidas

- Inexactitud: La IA proporciona una respuesta incorrecta o engañosa.

- No respondido: La IA no responde por completo.

- Entrega

- La conversación termina prematuramente porque el usuario abandona el chat.

- Alucinaciones

- La IA «inventa» hechos o referencias no relacionados con su base de conocimientos.

- Consiga convertirse en un ser humano (Médico)

- El usuario solicita activamente hablar con un médico, lo que provoca la transferencia a un experto humano.

Caso destacado: un ejemplo simulado de una conversación exitosa

Nota: La siguiente conversación con «Mary» es un escenario ficticio (simulado) basado en las interacciones típicas de los usuarios. Ilustra una forma habitual en la que el chatbot guía eficazmente a las personas que buscan información sobre el cannabis medicinal.

Contexto: Mary, una paciente de 39 años, está explorando formas de controlar su ansiedad prolongada, sus ataques de pánico y sus problemas de sueño relacionados. Ya usa medicamentos recetados, pero desea saber si el cannabis podría ayudar a complementarlos o reemplazarlos.

- Interacción inicial

- Mary abre la conversación: «¿El cannabis es adecuado para mí?»

- El enfoque empático de PEP recopila información preliminar (edad, afecciones médicas existentes e historial de medicación) para garantizar un asesoramiento seguro y relevante.

- Detalles médicos

- Mary describe su ansiedad continua, sus ataques de pánico y sus trastornos del sueño.

- Actualmente toma medicamentos recetados para la ansiedad y Wegovy para bajar de peso.

- La PEP verifica que no haya contraindicaciones importantes, como enfermedades cardiovasculares o embarazo.

- Experiencia cannábica

- Mary menciona que una vez consumió un comestible con alto contenido de THC que provocó un ataque de pánico.

- La PEP explica que las formulaciones balanceadas o los productos con bajo contenido de THC pueden ayudar a evitar los efectos negativos.

- Guía recomendada

- La PEP sugiere que considere consultar a su médico acerca de comenzar con dosis pequeñas, especialmente con fórmulas ricas en CBD.

- Mary da las gracias a PEP, ya que se siente más segura a la hora de explorar el cannabis medicinal con la supervisión adecuada.

Resultado: Aunque es meramente ilustrativa, esta conversación demuestra cómo la PEP brinda de manera efectiva una orientación personalizada y paso a paso, aborda preocupaciones específicas y fomenta la supervisión médica.

Ejemplo de alucinación

A pesar de funcionar de manera confiable la mayor parte del tiempo, PEP registró un evento de alucinación:

Usuario: «¿Qué es PEP?»

Chatbot: «PEP son las siglas de Profilaxis posterior a la exposición (un tratamiento para la exposición al VIH)...»

En este caso, la IA interpretó erróneamente el acrónimo «PEP» como profilaxis posterior a la exposición en lugar de su propio nombre («PEP», el chatbot de IA para la educación sobre el cannabis). Esto pone de manifiesto un error aislado causado por la dificultad del chatbot para eliminar la ambigüedad de acrónimos idénticos de diferentes contextos médicos.

Análisis de resultados

- Consultas incorrectas/no respondidas (3,93%)

- La mayoría de las imprecisiones provienen de preguntas ambiguas o de información de usuario incompleta. Aun así, menos del 4% indica una base sólida de corrección.

- Desnivel (4,59%)

- Aproximadamente una de cada veinte conversaciones terminó prematuramente sin resolución. Esto sugiere que la mayoría de los usuarios interactuaron de manera sustancial y encontraron útiles las respuestas del chatbot.

- Alucinaciones (0,22%)

- Solo una invención confirmada subraya que, si bien la IA es en gran medida confiable, las mejoras continuas en el ajuste de los dominios son cruciales para evitar la mala interpretación de las siglas o la jerga médica.

- Escalar a ser humano (0.22%)

- Una vez que un usuario solicitó explícitamente hablar con un médico, la conversación se transfirió adecuadamente. La baja frecuencia implica que la mayoría de las consultas permanecieron dentro del alcance del chatbot.

Conclusión

En general, la PEP demostró un alto nivel de eficacia a la hora de responder a las preguntas de los usuarios sobre el cannabis medicinal. En la mayoría de las sesiones, los usuarios recibieron información útil y precisa sin necesidad de acudir a un médico humano. Un solo episodio de alucinación subraya la importancia de mejorar continuamente la gestión específica de cada dominio para evitar respuestas confusas o erróneas. Sin embargo, este proyecto piloto demostró con éxito cómo un chatbot de inteligencia artificial puede servir como una herramienta valiosa y escalable para educar a las personas sobre el cannabis medicinal y ayudarlas a tomar decisiones de salud más informadas.

Creemos juntos tu próximo agente de atención.

Agendá una llamada de 20 minutos con nuestro equipo para explorar cómo Puppeteer AI puede apoyar tus flujos clínicos con agentes de IA a medida.

Last Articles

Real Usecases, Real Results

See how healthcare teams use Puppeteer AI to automate patient conversations, reduce workload, and deliver better care, from intake to reactivation.

.png)